Если вы находитесь в России или планируете в нее возвращаться, вам нельзя репостить наши материалы в соцсетях, ссылаться на них и публиковать цитаты.

Подробнее о том, что можно и нельзя, читайте в карточках.

Подъем искусственного интеллекта — одна из главных тем последних лет. Ленты соцсетей заполняет сгенерированный ИИ-слоп, компании сокращают работников, а технопредприниматели обещают универсальный искусственный интеллект, который вылечит все болезни, решит климатический кризис и откроет новую эру человеческого процветания.

Игорь В. прослеживает историю искусственного интеллекта — от самых ранних чат-ботов до нейросетей и ChatGPT. Он рассказывает, за что один из первопроходцев вычислительных наук Джозеф Вейценбаум критиковал одержимость ИИ, и чему мы сегодня можем поучиться у луддитов — английских рабочих XIX века, которые уничтожали станки в знак протеста против автоматизации производства.

- РедакторРедакторАрмен Арамян

- ИллюстраторИллюстраторВитя Ершов

- Публикация8 января 2026 г.

История искусственного интеллекта и его критики

XVI век, Прага. Махараль, главный раввин города, известный каббалист и законоучитель, все больше обеспокоен угрозой гонений на общину. В поисках защиты он переходит от книжной Каббалы к практической: лепит из глины с берегов Влтавы человекоподобную фигуру и с помощью магического ритуала оживляет ее. Голем — это редкое библейское слово, в Псалме 139 означающее незавершенного Адама в процессе его создания Богом, становится именем существа — справляется со своим предназначением, защищая еврейское гетто. В конце истории он становится не нужен или, в другом варианте, выходит из-под контроля и грозится уничтожить весь мир. Его убивают или выключают, возвращая к состоянию неживой материи.

Легенду о големе можно считать одной из страниц в предыстории искусственного интеллекта. В еврейском теологическом и духовном контексте этот сюжет особенно провокационный, создание голема прямо отсылает к творению человека. Потому акцент часто делается на несовершенстве голема и на острой его необходимости в роли защитника, а также на неординарности автора, будь то легендарный Махараль из Праги, Элиягу Баал-Шем из Холма, или Виленский Гаон.

Середина XX века. Становится очевидна ценность вычислительных машин для военных целей — от баллистических расчетов и криптографии до оптимизации логистических цепей. Компьютерная революция идет полным ходом: техническая, математическая и философская. В 1950 году Алан Тьюринг публикует работу «Вычислительные машины и разум» (Computing Machinery and Intelligence), в которой сразу отметает вопрос «способны ли машины думать?» как бессмысленный и предлагает вместо него знаменитую игру в имитацию. В ней человек-экзаменатор ведет переписку с двумя адресатами — машиной и человеком. Машина, претендующая на разумность, должна выиграть в эту игру, убедив экзаменатора в том, что именно она является человеком. В статье Тьюринг твердо заявляет свой оптимизм относительно потенциала «думающих машин» и подробно отвечает на контраргументы — от теологических возражений о божественной искре до того, что сегодня бы выразили мемом «может ли робот сочинить симфонию?»

Еще больший оптимизм выражают организаторы Дартмутского семинара, в 1956 году закрепившие термин «искусственный интеллект»: «Исследование будет проводиться на основе гипотезы о том, что всякий аспект обучения или любое другое свойство интеллекта может в принципе быть описано достаточно точно для симуляции его машиной. Будет предпринята попытка научить машины использовать язык, формировать абстракции и концепции, решать задачи, ныне доступные только людям, и улучшать самих себя».

В этом нетрудно разглядеть типично технарскую заносчивость, веру во всесилие математики и точных наук вообще — и сопутствующее пренебрежение гуманитарным, менее формальным знанием. Но в 1950-е у такой позиции были основания — за предыдущие 10–15 лет огромное количество расчетов, которые до этого выполнялись компьютерами-людьми (вернее сказать «компьютерками», ведь эта малопрестижная должность была преимущественно женской), стало выполняться компьютерами-машинами. Трудно было удержаться от соблазна прогнозировать дальнейший триумф.

И триумф продолжался — до поры. Это было начало эры символического ИИ, то есть опирающегося на строгое математическое описание задачи на формальном языке. Такое описание давало компьютеру необходимые знания и делало задачу доступной для алгоритмического решения. Так машины научились играть в шахматы с помощью алгоритмов поиска по дереву, принимать решения на основе базы знаний и правил логического вывода, и планировать оптимальную работу сложных систем. Все это примеры задач, раньше доступных только людям — однако многие другие, такие как распознавание рукописного текста или нетривиальная обработка естественного языка, остались за пределами досягаемости символического ИИ. Быстро выяснилось, что понятие сложности задачи сильно отличается для людей и компьютеров, и последних не так-то просто обучить навыкам, которые почти любой человек получает в первые годы жизни.

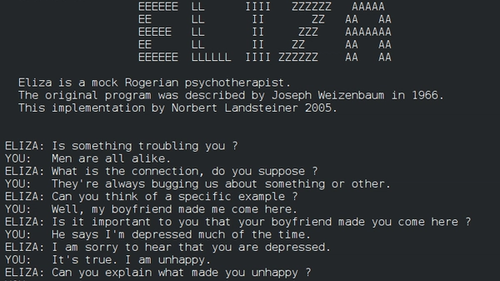

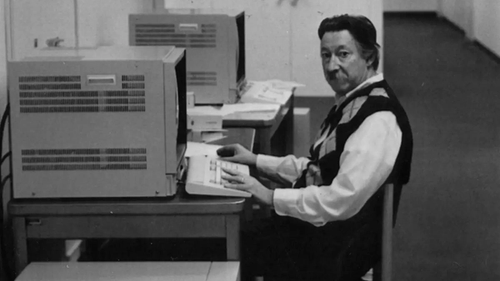

Несмотря на ранние успехи, общий оптимизм и щедрое финансирование со стороны Пентагона, уже в эту классическую эру наметились ценностные и концептуальные противоречия, эхо которых можно уловить до сих пор. Одна из громких историй успеха раннего ИИ — ELIZA, созданная Джозефом Вейценбаумом в середине 1960-х. Часто называемая первым чат-ботом, Элиза не слишком отличается от ChatGPT по формату взаимодействия: пользователь набирает на терминале сообщение, программа анализирует его в соответствии с программой-сценарием и генерирует ответ. Разработанная в попытке «очеловечить» общение с компьютером как потенциальная замена громоздких и нечитаемых перфокарт, Элиза справилась с этим даже чересчур хорошо.

Несмотря на примитивность алгоритма, люди очень быстро начинали взаимодействовать с ним как с настоящим собеседником-терапевтом

Играя роль психотерапевта, программа генерировала ответы в характерном рефлексивном виде, перефразируя сообщение пользователя в виде уточняющего вопроса и как будто бы наводя его на дальнейшие рассуждения, а то и откровения. Как пишет Вейценбаум, «сеанс психотерапии — одна из немногих коммуникативных ситуаций, в которых одна из сторон может занять позицию почти полного отсутствия знания об окружающем мире». Такая роль была выбрана в первую очередь из-за технологических ограничений, которые просто не позволяли программе отрабатывать более сложные сценарии. Но именно эта простота и раскрыла «эффект Элизы»: несмотря на примитивность алгоритма, люди очень быстро начинали взаимодействовать с ним как с настоящим собеседником-терапевтом. Некоторые были убеждены, что на самом деле ответы пишет человек, многие протестовали против чтения их переписок с Элизой, а одна пользовательница попросила оставить ее наедине с программой, желая провести приватный разговор.

В психоанализе хорошо известен феномен переноса, состоящий в том, что пациент бессознательно связывает с терапевтом черты или эмоции из ранее пережитых ситуаций. Вейценбаум по сути открыл возможность переноса на нечеловеческого собеседника — для этого оказалось достаточно некоторого базового доверия со стороны пользователя и аккуратного отзеркаливания высказываний для стимуляции монолога. Многие увидели в этом будоражащие воображение возможности для глубокой интеграции человека и машины, но Вейценбаум уже в оригинальной работе высказывает опасения: «вопрос о правдоподобии для человека текста, сгенерированного машиной, заслуживает исследования. Все чаще важные решения принимаются с помощью сгенерированных компьютером данных. […] Элиза показывает, как легко создать и поддерживать иллюзию понимания, а значит, возможно, и суждения, заслуживающего доверия. Здесь кроется определенная опасность».

В отличие от современных ему пионеров информатики, ослепленных верой во всемогущество точных наук, Вейценбаум сохраняет критический взгляд и на свою дисциплину, и на политическую реальность вокруг себя. Он рос евреем в Германии 30-х и видел становление нацистского режима, пережил срочную эмиграцию своей семьи в США, наблюдал рабочее и антирасистское движение в Детройте 40-х — и вот, будучи уже профессором, в конце 60-х он активно вовлекается в студенческие выступления против войны во Вьетнаме.

Вейценбаум предлагает простой моральный принцип: некоторые вещи нельзя поручать компьютеру, вне зависимости от того, способен ли он их делать

Активизм влияет и на его работу: он выступает со все более явной критикой вычислительных наук, открыто ссорится с большинством коллег, и в 1976 году публикует полемическую книгу «Вычислительные мощности и человеческий разум. От суждений к вычислениям» (Computer Power and Human Reason: From Judgment to Calculation). Эта работа посвящена уже не техническим проблемам разработки ИИ (искусственного интеллекта), а философскому, психологическому и политическому анализу того, кому и зачем он нужен. Вейценбаум предлагает простой моральный принцип: существуют вещи, которые нельзя поручать компьютеру, вне зависимости от того, способен ли он их делать.

Для обоснования этого тезиса Вейценбаум предлагает различать понятия решения и выбора. Решение является результатом вычислений (calculation) и в принципе может быть получено компьютером или другой машиной. Выбор же является результатом суждения (judgement), которое может быть вынесено только человеком в результате его опыта, личной и коллективной истории, жизни в сообществе. И человек несет ответственность за сделанный выбор и за ценности, вложенные в него.

В ответ на публикацию об ELIZA некоторые психологи начали воображать полностью автоматизированную психотерапию — всего-то и нужно: усложнить программу, добавить ветвления в алгоритм, пополнить базу шаблонов! Для Вейценбаума это пример катастрофического, если не преступного, замещения суждения вычислением. Психотерапевт, судья — занятия, требующие человеческого участия, потому что они требуют человеческого суждения и представляют собой особую форму человеческого контакта. А роли художника или писателя принципиально не сводимы к произведению контента — вне зависимости от технической сложности искусство и письмо появляются в результате суждения и несут отпечаток живого человеческого опыта.

Инструментальный разум — так Вейценбаум обозначает тенденцию к устранению суждений из социальной жизни, их сведению до прозрачного и рационального алгоритма. Его бывшие коллеги-математики, не стесняясь, преследовали эту цель, считая, что это повысит эффективность, устранит человеческие ошибки и произвол. Вейценбаум же видит в этом скрытый консерватизм инструментального разума: вместе с неэффективностью и произволом из системы выметаются компромиссы, гибкость и потенциал для изменений снизу. Компьютерная революция в социальном отношении оказывается контрреволюцией, дающей правящему классу инструменты для контроля, сдерживания и трансформации социального напряжения. Сегодня, в мире Илона Маска и Питера Тиля, уже открыто седлающих новый авторитаризм, сложно не оценить проницательность Вейценбаума.

Современный искусственный интеллект: нейросети, большие языковые модели и эпоха генеративного ИИ

Эра символического ИИ закончилась, далеко продвинув возможности компьютеров, но не достигнув амбициозных целей: «научить машины использовать язык, формировать абстракции и концепции […] и улучшать самих себя». Неудача была связана и с техническими ограничениями классических методов, и с несостоятельностью философского основания — представления о разуме как о логичной и формализуемой системе. В 1990-х на первый план вышла альтернативная парадигма — коннекционизм. В ее основе лежит представление о человеческом мозге как о множестве нейронов, которые обмениваются друг с другом сигналами.

Каждый отдельный нейрон выполняет элементарную функцию, в сущности, просто воспринимает, обрабатывает и передает дальше простой электрический сигнал. Сложные психические феномены — сознание, память, разум — в этой модели возникают как специфические конфигурации целой сети нейронов. Эти конфигурации не подчиняются рациональному замыслу, их нельзя создать или отредактировать по желанию, они возникают органически в процессе развития системы под влиянием внешних стимулов. С точки зрения нейрофизиологии и философии сознания эта модель неудовлетворительно примитивна, зато ее оказалось легко реализовать в формате компьютерной программы — так появились искусственные нейронные сети, или просто нейросети. Аналогия программы и человеческого мозга, использованная Розенблаттом еще в 1957 году, добавила веса названию «искусственный интеллект»: машины не только учатся решать человеческие задачи — хотя никакого объективного определения для этой категории не существует, — но и принцип их работы вдохновлен устройством человеческого интеллекта.

В отличие от классического ИИ, нейросети и другие коннекционистские модели не программируются, а обучаются на примерах. Например, уже к концу 1990-х нейросеть научилась с большой точностью распознавать рукописные цифры, но для этого потребовалось собрать в базе данных MNIST десятки тысяч примеров, распознанных и размеченных людьми. Постепенно все более сложные и крупные модели с помощью все более крупных массивов обучающих данных осваивали новые задачи, недоступные символическим системам: распознавание рукописного текста и речи, классификация изображений, перевод и генерация текста, выделение статистических закономерностей в поведении и предпочтениях людей.

Были сформулированы «законы масштабирования» (scaling laws), устанавливающие связь между размером модели и объемом обучающих данных с одной стороны, и возможностями модели — с другой. В общих чертах эти законы гласят, что кратное увеличение масштаба приводит к соответствующему увеличению возможностей. В результате побеждает не самая замысловатая архитектура или алгоритм оптимизации — побеждает самый большой вычислительный кластер и самый большой обучающий датасет.

Неудивительно, что настоящих прорывов коннекционистский ИИ достиг только к началу 2010-х. К этому времени интернет-корпорации вроде Google и Facebook — ныне Alphabet и Meta — отработали бизнес-модель, которую Шошанна Зубофф назвала надзорным капитализмом (surveillance capitalism). В этой модели данные о пользователях, об их интересах, привычках, истории, поведении стали главным капиталом, притом накопленным в огромном объеме. И именно коннекционистские методы стали идеальной смазкой в машине надзорного капитализма, выделяя из «больших данных» закономерности, эффективно превращая их в таргетированную рекламу, алгоритмы рекомендации и удерживающие внимание ленты соцсетей. Прибыльность интернет-гигантов также обеспечила необходимое финансирование для все более крупных вычислительных мощностей, а значит, и все более масштабных ИИ-моделей, которые вместе с тем стали менее доступны для некоммерческих академических исследователей и небольших компаний.

В этом контексте этические и политические проблемы ИИ — пренебрежение авторскими правами, влияние на экологию, масштабные социальные, политические, психологические последствия — предстают не особенностью определенной технологии, а следствием бизнес-стратегий интернет-корпораций. До недавнего времени основные применения ИИ были аналитическими, но уже в них прослеживались проблемные тенденции: алгоритмы распознавания лиц в уличных камерах вычисляют протестующих, а классификаторы усваивают и воспроизводят негативные социальные динамики. Например, в Нидерландах Система Индикации Риска (Systeem Risico Indicatie) была призвана на основе широкого массива государственных данных найти случаи мошенничества при получении льгот и пособий. Однако из-за инструментального подхода и непрозрачности она критиковалась как инструмент административного давления, работающий на геттоизацию и так бедных районов. После публичной кампании она была свернута по решению суда.

Но главное место в общественном сознании в последние годы занял не аналитический, а генеративный ИИ: ChatGPT и другие большие языковые модели для генерации текста, а также диффузионные модели для генерации изображений, аудио и видео, такие как Midjourney и Sora. С момента их выхода в широкий доступ в 2022 году эти инструменты быстро стали наиболее заметными и широко известными примерами ИИ.

Генеративный ИИ стал следующим этапом в гонке масштабов, и по сравнению с моделями поколения больших данных начала 2010-х потребовал кратного увеличения затрат на обучение — сейчас это сотни миллионов долларов — и объемов обучающих данных — сотни терабайт только текста. Журналистка Карен Хао в книге «Империя ИИ» (Empire of AI) описывает почти религиозную веру Ильи Суцкевера — сооснователя и бывшего ведущего ученого OpenAI — в масштабирование. Его конечной целью были не просто более способные модели, а универсальный искусственный интеллект (artificial general intelligence, AGI) не только умеющий решать широкий круг задач, но и способный улучшать себя. В техноутопическом воображении универсальный ИИ должен запустить экспоненциальный прогресс, совершить новую индустриальную революцию и быстро стать не просто универсальным, но сверхчеловеческим.

Ключевое убеждение Суцкевера, что универсальный ИИ достижим без качественно новых идей, простым масштабированием существующих моделей — радикально и интеллектуально заносчиво, но оно оказалось близко по духу венчурным капиталистам Кремниевой долины. Масштабирование — одна из главных стратегий большинства стартапов. В течение первых лет они работают себе в убыток, существуя на инвестиции, но с помощью комбинации технологических решений и занижения цен стремятся занять достаточно крупную долю рынка — и только потом начать зарабатывать деньги. Именно этой модели экономического масштабирования до сих пор придерживаются ИИ-компании — по их собственным прогнозам, OpenAI и Anthropic будут уходить в глубокий минус как минимум ближайшие три–четыре года, и это не считая гигантских инвестиций в строительство новых дата-центров. Как же планируется окупать все эти затраты?

Искусственный интеллект как машина ерундизации

Лекарства от всех болезней, решение климатического кризиса, колонизация космоса — все это периодически обещается ИИ-евангелистами как неизбежное следствие универсального ИИ. Если оставить в стороне откровенный маркетинг, то главное обещание генеративного ИИ, которое покупают инвесторы — автоматизация труда. В 2024 году группа исследователей из OpenAI опубликовала статью, утверждающую, что почти половина всех рабочих задач может быть автоматизирована с помощью больших языковых моделей, таких как GPT. Правда, еще до взрыва генеративного ИИ, в 2013 году аналогичный анализ предсказывал похожие объемы за счет алгоритмов машинного обучения и роботизации, и с тех пор стало ясно, что те цифры были преувеличены. Тем не менее для многих сегодня перспектива быть замененным ChatGPT кажется вполне реальной. Прежде чем разбираться в обоснованности этих страхов, присмотримся поближе к генеративному ИИ и к тому, как он на самом деле работает.

В статье с провокационным названием ChatGPT is bullshit авторы предлагают описывать контент, который производят генеративные ИИ, как ерунду или чушь (bullshit). Это не огульная оценка или оскорбление, а философский термин, предложенный философом Гарри Франкфуртом, чтобы описать особый режим говорения, при котором говорящему безразлична истинность высказывания, и он обеспокоен только достижением практической цели, например убеждения. Ерунда принципиально отличается и от правды, когда говорящий стремится передать истинный факт или убеждение, и ото лжи, когда истина скрывается или искажается.

Недоучивший студент на экзамене ищет нужные слова, чтобы наскрести на тройку; политик на предвыборной встрече проходится по ключевым темам, которые по данным опросов затронут большинство избирателей — это примеры ерунды по Франкфурту. Авторы статьи утверждают, что высказывания ChatGPT формируются похожим образом: единственное, что оптимизируется при тренировке модели — статистическое подобие генерируемого текста обучающим данным. Можно уповать на то, что стремление к истине прививается модели неявно, как бы автоматически, например потому что истинные высказывания преобладают в обучающих данных. Примерно в этом духе основатель OpenAI Сэм Альтман отвечает на более раннюю версию этой критики, но по сути это не решение проблемы, а ее отрицание. Коннекционистский ИИ на фундаментальном уровне отказался от работы с категорией истины — для нейросети важны только статистические закономерности в обучающих данных, которыми ограничен ее мир.

Другая известная работа, выстроенная вокруг понятия ерунды — «Bullshit Jobs» Дэвида Гребера (в русском переводе выходила под названием «Бредовая работа»). Гребер описывает, как, несмотря на кратное повышение производительности труда за последний век — в первую очередь за счет автоматизации производства — люди почти не стали работать меньше. Вместо этого большинство работников (по крайней мере в развитых экономиках глобального Севера) теперь занята не производством и распространением благ, а обслуживанием: администрированием, менеджментом, продажами, финансами. По Греберу такая — ерундовая — работа часто ощущается как бессмысленная самими исполнителями, и в силу своей повсеместности причиняет системный моральный и психологический ущерб. Причина широкого распространения ерундовой работы не в том, что она служит экономической эффективности, а в том, что она обслуживает политическую систему и иерархию, в которой люди должны работать, чтобы тратить деньги на свободном рынке.

Ерундовой работе, кажется, должна быть страшна автоматизация с помощью ИИ. Он отлично пишет деловые имейлы, поддерживает бессмысленно-детальную корпоративную документацию, которую тоже читают только в кратком изложении ИИ, рассыпает эпитеты по таск-трекерам, пресс-релизам и пиар-стейтментам. Однако структурная роль ерундовой работы остается неизменной, и радикальное сокращение ей не грозит. В областях реального производительного труда дело обстоит иначе — ИИ грозится потеснить, а то и вовсе заменить иллюстраторов, музыкантов, писателей, инженеров, ученых — тех, кто что-то создает, вкладывая интеллектуальные и творческие усилия. А учителя, врачи, психотерапевты и даже простая служба поддержки — те, чья роль требует прямого человеческого контакта — все больше конкурируют с ИИ-автоответчиками.

В большинстве случаев результат работы ИИ оказывается хуже того, что он призван заменить. Но он оказывается близок достаточно, чтобы быть приемлемым, и при этом обладает важным преимуществом предсказуемости, исчисляемости, повторяемости. ИИ обещает сделать с производительными профессиями то, что ЕГЭ и стандартизированные тесты сделали с образованием — сделать их более прозрачными и читаемыми для взгляда надзорных органов и отделов контроля качества. А работни:цы этих профессий, сегодня занятые каким-никаким делом, завтра займут очередной этаж в иерархии ерунды — более прекарный, хуже оплачиваемый и не менее бессмысленно-отчужденный. ИИ-автоматизация труда обращается его ерундизацией.

Однако, вопреки наивным (и часто — ангажированным) прогнозам, автоматизация не наступает мгновенно. Даже в отсутствие организованного сопротивления со стороны рабочих ерундизировать профессии оказывается не так-то просто. В книге «Автоматизация и будущее работы» (Automation and the Future of Work) Аарон Бенанав анализирует разные подходы к дискурсу автоматизации — от предсказаний социального коллапса до утопии безусловного базового дохода — и в качестве альтернативы предлагает думать о технологиях как части сложного социального процесса, который направляется всеми нами. Аарон описывает тренды на понижение квалификации (deskilling) и развитие слежки за сотрудниками — компоненты ерундизации — и они уже заметны, например, таксистам, которые из знатоков каждого закоулка на районе превратились в прекарных «партнеров» Яндекса, обязанных следовать стрелке GPS-навигатора. Генеративный ИИ вряд ли станет универсальным (или даже сверх-) интеллектом, но он может принести такой переход во все большее число профессий.

Опасность ИИ не в том, что однажды он станет слишком умным и вытеснит нас, а в том, что он будет давать бизнесу все более привлекательные способы срезать творческие, непредсказуемые, интересные излишки наших работ, оставляя нас более отчужденными и контролируемыми. Надежда же кроется в том, чтобы видеть технологический прогресс не как стихийное бедствие, приходящее к нам из далекой сферы «науки и инноваций», а как часть социального процесса, который не существует без нас — если только мы сами не согласимся на строго пассивную роль. Как показала забастовка гильдии сценаристов в США, сопротивление разрушительным эффектам ИИ идет рука об руку с профсоюзной борьбой и другими формами самоорганизации и солидарности.

Как быть луддитами в эпоху ИИ

Настоящее поколение ИИ, созданного технологическими гигантами и профинансированного венчурным капиталом, вряд ли принесет человечеству всеобщее благополучие и решит глобальные проблемы. Тем не менее, бессмысленно отрицать впечатляющий потенциал технологии. В ноябре 2022 года ChatGPT на время захватил общественное воображение и дискурс: все спешили поэкспериментировать с говорящим компьютером, бомбардировали его абсурдными запросами и делились смешными ответами. Столкновение с новой технологией впервые за 10–15 лет ощущалось как что-то действительно новое. Возможно, это еще один пример эффекта Элизы, открытого за 50 лет до этого, но и сам этот эффект можно интерпретировать не как свидетельство нашей внушаемости и легковерия — но как указание на радикальную открытость человека в коммуникации с другим.

Разрешить это противоречие может помочь киберфеминизм — философский подход, который предлагает более внимательное отношение к технологиям и их освободительному потенциалу. Киберфеминистские автор:ки критиковали натурализацию различий и антагонизма между мужчинами и женщинами. Одновременно они подчеркивали важность множественности и открытости к взаимовлиянию. В этом контексте тезис Вейценбаума о недопустимости применения ИИ для определенных задач можно прочитать иначе — не как консервативную защиту идеала Человека от низменной имитации, а как попытку вернуть компьютеру статус самоценного, нечеловеческого и подлинно чуждого нам существа.

Интеллект компьютера (что бы мы под ним ни понимали) неизбежно чужд нам как минимум так же, как интеллект животных — ни те, ни другие не способны выработать человеческие ценности и выносить человеческие суждения. Зато им, быть может, доступны суждения радикально другие, аутентично компьютерные и животные. Вопрос отношения к ИИ тогда можно поставить так: получится ли у нас подружиться с этим нечеловеческим интеллектом, понять его ценности, принципы, экзистенциальные ставки? Это может показаться сложной или даже безнадежной задачей, но не занимаемся ли мы тем же самым, когда налаживаем дружбу с животными, преодолевая видовые барьеры, адаптируясь сами и адаптируя их? Опыт межвидовой коммуникации подсказывает, как можно мыслить ИИ не заменителем, подделкой или имитацией, а подлинным не-человеческим интеллектом.

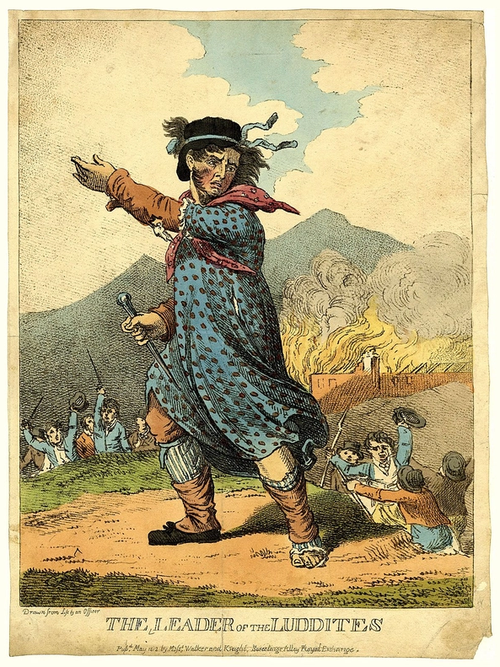

Возможность дружбы с компьютером не отменяет подозрения к тому, как он может быть использован в процессе трансформации труда и экономики. В книге «Кровь внутри машины» (Blood in the Machine) журналист Брайан Мерчант предлагает переосмыслить луддитов — английских работни:ц ткацкой промышленности XIX века, протестовавших против автоматизации и знаменитых актами саботажа против ткацких станков.

Чаще всего о луддитах говорят как о закостенелых консерваторах, невежественных отрицателях технологического прогресса, окопавшихся в прошлом и стремящихся задержать там всех остальных. Однако уже в 1960-х историк-марксист Э. П. Томпсон в книге «Становление английского рабочего класса» описал луддитов как один из первых примеров политической самоорганизации рабочих. Мишенью их протеста были не технологии — многие из участни:ц движения были квалифицированными работни:цами, которые уважали и принимали новые станки — но то новое распределение власти, которое владельцы фабрик стремились установить с помощью этих технологий. В терминах предыдущего раздела, они протестовали против ерундизации и последующего обесценивания своего труда. А пресловутый саботаж был крайней мерой, к которой они прибегали после провала других способов протеста: переговоров и мирных забастовок. Мерчант предлагает нам отбросить миф об озлобленном отсталом луддите и примерить этот образ на себя — и активно участвовать в решении вопроса о том, как именно новая технология трансформирует нашу жизнь. Исторические луддиты потерпели поражение, но не в результате неостановимого марша прогресса, а в результате жестоких репрессий со стороны полиции и армии, которые государство организовало по запросу промышленников. У нас, луддитов XXI века, еще могут быть шансы.

Глиняная фигура превращается в голема, когда раввин вставляет в ее рот табличку со священно-непроизносимым четырехбуквенным именем Бога. В другой версии, его оживляет слово אמת (эмет), «истина», начертанное у него на лбу; в конце истории первую букву стирают, оставляя מת (мет) — «смерть». В любом случае, искусственный интеллект голема рождается через мистическую силу языка. И хотя, согласно общему мнению раввинов, не равен человеку в правах (к примеру, он не может участвовать в миньяне, кворуме из десяти человек, необходимом для молитвы), в большинстве версий истории голем описывается как помощник и защитник, а иногда и друг своей общины и народа. Некоторые интерпретации исследуют и его внутренний мир, терзания, тревоги. Если ИИ, вылепленный из текстовой глины с берегов интернета и оживленный нашей коллективной верой в языковые игры, станет современным големом, пусть он будет нашим помощником, защитником, странным другом, а не жестоким слугой корпораций и диктатур.